0. Bu Yazı Nasıl Okunmalı?

Bu dokümantasyon, Docker’ı sıfırdan öğrenmek isteyenler için kapsamlı bir rehber olarak hazırlandı. Ancak bu sadece bir blog yazısı değil — aynı zamanda bir başvuru kaynağı ve pratik bir kılavuz.

Yazının Yapısı ve Okuma Stratejisi

Bu yazı kademeli derinleşme prensibiyle oluşturuldu. İlk bölümler temel kavramları tanıtırken, ilerleyen bölümler production ortamları, güvenlik, performans optimizasyonu gibi ileri seviye konulara giriyor. Bu yüzden:

Eğer yeni başlıyorsanız: Sırayla, baştan sona okuyun. Her bölüm bir öncekinin üzerine inşa edilmiştir. Konuları atlamak, ileride anlama zorluğu yaratabilir.

Eğer belirli bir sorunu çözmek istiyorsanız: İçindekiler bölümünden ihtiyacınız olan konuya atlayın. Her bölüm mümkün olduğunca bağımsız yazılmaya çalışıldı.

Eğer bilginizi pekiştirmek istiyorsanız: İlgilendiğiniz bölümleri seçerek okuyun, ancak örnekleri mutlaka test edin.

Önemli Uyarılar

-

Yavaş okuyun. Özellikle 10. bölümden sonra teknik detaylar artıyor. Acele ederseniz önemli noktalari kaçırabilirsiniz.

-

Pratik yapın. Sadece okumak yeterli değil. Örnekleri kendi bilgisayarınızda çalıştırın, hata yapın, düzeltin. Yazılım öğrenmek bir zanaat — deneyerek öğrenilir.

-

Parçalara bölün. Bu yazıyı tek oturuşta okumaya çalışmayın. Her gün bir-iki bölüm üzerinde çalışmak, tüm yazıyı bir gecede geçiştirmekten çok daha etkilidir.

-

Not alın. Önemli komutları, kendi projeleriniz için uyarlayabileceğiniz pattern’leri, karşılaştığınız sorunları not edin. Bu yazı bir referans kaynağıdır, sık sık geri döneceksiniz.

Hedef Kitle

- Yazılım geliştiriciler (backend, frontend, full-stack)

- DevOps mühendisleri ve sistem yöneticileri

- Docker’a yeni başlayanlar

- Mevcut Docker bilgisini derinleştirmek isteyenler

- Production ortamlarında Docker kullanacak ekipler

Bu Yazının Felsefesi

Teori + Pratik = Öğrenme. Her kavram hem teorik olarak açıklandı hem de çalışan kod örnekleriyle gösterildi. “Neden?” ve “Nasıl?” sorularının ikisine de yanıt vermeye çalıştım.

Sade dil. Gereksiz jargondan kaçındım. Teknik terimler kullanıldığında açıklandı. Anlaşılır olmak, teknik derinlikten daha önemli.

Gerçek dünya senaryoları. Production ortamında karşılaşacağınız problemler, anti-pattern’ler ve çözümleri de dahil edildi. Bu sadece “nasıl çalıştırılır” değil, “nasıl doğru çalıştırılır” rehberi.

Başlamadan Önce

Docker’ı bilgisayarınıza kurmuş olduğunuzdan emin olun. Kurulum talimatları Bölüm 3’te detaylı anlatılıyor. Terminal veya PowerShell kullanmaktan çekinmiyorsanız, hazırsınız demektir.

Şimdi, lafı daha fazla uzatmadan, Docker’ın ne olduğunu ve neden bu kadar önemli olduğunu anlamaya başlayalım.

1. Giriş / Neden Docker?

1.1 Kısa Özet: Konteyner Nedir, VM’den Farkı?

Uygulamaları çalıştırmanın iki yolunu elimize alalım:

-

Doğrudan işletim sistemine kurmak

-

Sanal makine (VM) kullanmak

Sanal makinelerde (örneğin VirtualBox, VMware) her bir makine kendi işletim sistemine sahiptir. Bu da çok fazla sistem kaynağı tükenmesine (RAM, CPU, disk alanı) ve başlatılmasınınzaman alması demektir.

Konteyner teknolojisi ise farklı bir yaklaşım getirir. Konteynerler, işletim sisteminin çekirdeğini ortak kullanır; sadece uygulamanın çalışması için gerekli kütüphaneleri ve bağımlılıkları içerir. Sadece gereklilikleri izole olarak çalıştırır, Yani:

-

Daha hafif,

-

Daha hızlı açılır,

-

Taşınabilir (her yerde çalışır) hale gelir.

Özetle:

-

VM = Tüm bilgisayarı taklit eder.

-

Konteyner = Sadece uygulamanın ihtiyacını izole edip çalıştırır.

1.2 Neden Docker?

Peki konteynerleri yönetmek için neden Docker kullanıyoruz? Çünkü Docker:

-

Taşınabilirlik sağlar: Bir uygulamayı kendi bilgisayarında çalıştırdığın şekilde sunucuda da çalıştırabilirsin. “Benim bilgisayarımda çalışıyor ama sende çalışmıyor” sorunu ortadan kalkar.

-

Hızlı dağıtım sunar: Birkaç saniyede konteyneri ayağa kaldırıp silebilirsin. Geleneksel kurulum süreçleri saatler sürebilirken Docker ile dakikalar, hatta saniyeler yeterli. Tüm sistemi kurmanıza gerek kalmaz sadece gereklilikleri kurar ve projeyi ayağa kaldırmanızı sağlar.

-

Standart bir ekosistemdir: Docker Hub üzerinden milyonlarca hazır imajı (nginx, mysql, redis gibi) indirip anında kullanabilirsin.

-

Modern yazılım pratiklerine uygundur: Mikroservis mimarisi, CI/CD, DevOps süreçlerinde Docker artık neredeyse zorunlu bir araç hâline gelmiştir.

1.3 Bu Yazıdan Kimler Nasıl Faydalanır?

Bu yazı, Docker’a yeni başlayanlar, yazılımcılar, teknik altyapıya ilgi duyanlar ve sistem yöneticileri için hazırlanmış hem bilgilendirici hem de rehber niteliğinde bir blog olarak tasarlandı.

Amacım, Docker kavramlarını sadece teknik terimlerle değil, basit ve anlaşılır bir dille anlatmak. Teoriyi pratiğe dönüştürerek, okuyucuların Docker’ı kendi projelerinde güvenle kullanabilmesini sağlamayı hedefliyorum.

Bu blog-dökümantasyon:

- Linux ve Windows ortamlarında uygulanabilir,

- Teoriden çok pratiğe odaklı,

- Karmaşık jargon yerine sade bir anlatım sunar,

- Adım adım ilerleyen bir öğrenme yolu sağlar.

Kısacası: Bu yazı, Docker’a yeni başlayanlardan sistem yöneticilerine kadar herkes için hazırlanmış, hem blog hem de rehber niteliğinde bir kaynaktır. Basit, jargon içermeyen anlatımıyla teoriyi pratiğe dönüştürerek Docker’ı öğrenmeyi hızlı, sade ve etkili hâle getirmeyi hedefledim.

2. Docker Ekosistemi ve Temel Bileşenler (Docker’ın Kendi Araçları)

Docker sadece “konteyner çalıştıran bir yazılım” değildir. Onun etrafında birçok araç, bileşen ve standart gelişmiştir. Bunları bilmek, Docker’ın nasıl çalıştığını anlamak ve onu kullanabilmek için önemlidir.

2.1 Docker Engine (Daemon & CLI)

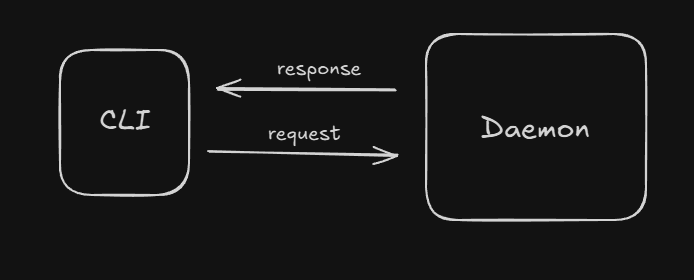

Docker Engine, Docker’ın kalbidir. Arka planda çalışan daemon (dockerd) konteynerlerin yönetiminden sorumludur. Örnek olarak: başlatma, durdurma, network, volume

Burada bizim kullandığımız kısım Docker CLI (docker run, docker ps, docker build gibi komutlardır). CLI, daemon ile konuşur ve emirleri uygulatır.

Özet: CLI = Kullanıcı arabirimi, Daemon = Motor.

2.2 Docker CLI komutları

Docker container

Konteyner yönetimi komutları:

| Komut | Açıklama |

|---|---|

docker container run |

Yeni bir konteyner oluşturur ve çalıştırır (Docker Documentation) |

docker container create |

Konteyneri oluşturur ama çalıştırmaz (Docker Documentation) |

docker container ls / docker container list |

Çalışan konteynerleri listeler (Docker Documentation) |

docker container stop |

Çalışan konteyneri durdurur (Docker Documentation) |

docker container start |

Durdurulmuş bir konteyneri başlatır (Docker Documentation) |

docker container rm |

Bir konteyneri siler (kapatılmış olmalı) (Docker Documentation) |

docker container logs |

Bir konteynerin log verilerini gösterir (Docker Documentation) |

docker container exec |

Çalışan bir konteyner içinde komut çalıştırır (Docker Documentation) |

docker container inspect |

Konteynerin detaylı yapılandırmasını gösterir (Docker Documentation) |

docker container stats |

Kaynak kullanım istatistiklerini gerçek zamanlı gösterir (Docker Documentation) |

docker container pause / docker container unpause |

Konteyneri geçici durdur / tekrar devam ettir (Docker Documentation) |

docker container kill |

Konteyneri aniden durdurur (SIGKILL) (Docker Documentation) |

Docker image

İmaj (image) yönetimi:

-

docker image ls/docker images— sistemdeki imajları listeler (Docker Documentation) -

docker image rm/docker rmi— bir ya da daha fazla imajı siler (Docker Documentation) -

docker image prune— kullanılmayan (dangling) imajları temizler (Docker Documentation)

Docker build

Dockerfile’dan imaj oluşturma:

-

docker build— Dockerfile’a göre imaj inşa eder (Docker Documentation) -

--no-cachegibi bayraklarla cache kullanımını devre dışı bırakma (Docker Documentation)

Genel Komutlar

-

docker version— CLI ile daemon versiyon bilgisini gösterir -

docker info— Docker ortamının durumunu, sistem detaylarını gösterir -

docker system— sistemle ilgili komutlar (örneğin kaynak temizleme, disk kullanımı) -

docker --helpveyadocker <komut> --help— komutların yardım bilgisini gösterir

2.2.1 Docker CLI Parametreleri — Detaylı Açıklama ve Örnekler

Docker CLI komutlarında kullanılan parametreler:

| Parametre | Açıklama | Örnek (Linux) |

|---|---|---|

-it |

İnteraktif terminal sağlar. | docker run -it ubuntu bash |

-d |

Detached mode (arka planda çalıştırır). | docker run -d nginx |

--rm |

Konteyner durdurulduğunda otomatik siler. | docker run --rm alpine echo "Hello" |

-p |

Port yönlendirme (host:container). | docker run -p 8080:80 nginx |

-v / --volume |

Volume mount ile dosya paylaşımı sağlar. | docker run -v /host/data:/container/data alpine |

--name |

Konteyner için özel isim atar. | docker run --name mynginx -d nginx |

-e / --env |

Ortam değişkenleri tanımlar. | docker run -e MYVAR=value alpine env |

--network |

Konteynerin bağlanacağı network’ü belirler. | docker run --network mynet alpine |

--restart |

Konteyner yeniden başlatma politikasını ayarlar. | docker run --restart always nginx |

2.3 Dockerfile & BuildKit (build optimizasyonu)

Dockerfile, Docker imajlarını tanımlayan tarif dosyasıdır. İçinde hangi temel imaj kullanılacağı, hangi paketlerin kurulacağı, hangi dosyaların kopyalanacağı ve hangi komutların çalıştırılacağı gibi bilgiler yer alır.

Dockerfile Temelleri

Örnek basit Dockerfile:

FROM python:3.11-slim

WORKDIR /app

COPY requirements.txt .

RUN pip install --no-cache-dir -r requirements.txt

COPY . .

CMD ["python", "app.py"]

Temel komutlar:

FROM→ temel imaj belirlerWORKDIR→ çalışma dizinini ayarlarCOPY/ADD→ dosya kopyalamaRUN→ imaj inşa sürecinde komut çalıştırmaCMD→ konteyner başlatıldığında çalışacak komut

Docker BuildKit Nedir?

BuildKit, Docker’ın build sürecini daha hızlı, verimli ve güvenli hale getiren modern build motorudur.

Docker 18.09’dan itibaren opsiyonel olarak kullanılabilmiş, Docker 20+ ile artık varsayılan olarak aktiftir.

Avantajları:

- Paralel build adımları (daha hızlı)

- Layer cache optimizasyonu (disk ve zaman tasarrufu)

- Inline cache kullanımı

- Build output’ların daha iyi kontrolü

- Build secrets yönetimi

- Daha temiz ve küçük imajlar

BuildKit Kullanımı

Docker’da BuildKit’i aktif etmek için:

export DOCKER_BUILDKIT=1 # Linux/macOS

setx DOCKER_BUILDKIT 1 # Windows (PowerShell)

Docker build komutu:

docker build -t myapp:latest .

BuildKit ile aynı komut:

DOCKER_BUILDKIT=1 docker build -t myapp:latest .

BuildKit’in Özellikleri

-

Secret Yönetimi Şifreler, API anahtarları gibi hassas bilgileri build sürecinde güvenli şekilde kullanabilirsin.

# syntax=docker/dockerfile:1.4 FROM alpine RUN --mount=type=secret,id=mysecret cat /run/secrets/mysecretBuild komutu:

DOCKER_BUILDKIT=1 docker build --secret id=mysecret,src=secret.txt . -

Cache Yönetimi

--cache-fromile önceden build edilmiş imajlardan cache kullanabilirsin.docker build --cache-from=myapp:cache -t myapp:latest . -

Parallel Build Bağımsız katmanlar aynı anda build edilir, build süresi kısalır.

-

Multi-stage Builds Daha küçük ve optimize edilmiş imajlar için build sürecini birden çok aşamada tanımlayabilirsin.

FROM golang:1.20 AS builder

WORKDIR /app

COPY . .

RUN go build -o app

FROM alpine:latest

WORKDIR /app

COPY --from=builder /app/app .

CMD ["./app"]

BuildKit, Docker build sürecinde performans, güvenlik ve yönetilebilirlik sağlar. Büyük ve karmaşık projelerde BuildKit kullanmak, imaj boyutunu azaltır, build süresini kısaltır ve hassas bilgilerin güvenliğini artırır.

2.4 Docker Compose (tek makinede multi-container)

Çoğu gerçek hayat uygulaması tek bir konteyner ile çalışmaz. Genelde modüler olması için her işlem için ayrı bir konteyner açılır. Eğer bir sistem çökerse diğer sistemlerinde çökmemesi için bu gereklidir. Bu yapının adı Modüler Yapıdır. Misal bir saas projesinde her api için ayrı bir konteyner açmak hem sistemde bir sorun olduğunda diğer sistemlerin çökmesini ve bozulmasını engeller ve sistem sorunları ile baş etmede yardımcı olur.

Örneğin:

-

Bir web uygulaması + veritabanı (MySQL/Postgres) + önbellek (Redis)

-

Bir API servisi + mesaj kuyruğu (RabbitMQ/Kafka)

Ek olarak bu sistemi kurduğunuzda hepsini tek tek docker run ile başlatmak karmaşık ve hataya açık olur. İşte burada Docker Compose devreye girer. Hem modüler bir yapı yapmanızda hemde bunun kontrolünü kaybetmemeniz için en güzel seçeneğiniz Docker Compose olacaktır.

Docker Compose Nedir?

-

Bir YAML dosyası (

docker-compose.yml) üzerinden, birden fazla servisi tanımlayıp yönetmeye yarar. -

Tek komutla (

docker compose up) tüm sistemi ayağa kaldırabilir,docker compose downile temizleyebilirsiniz. -

Ortak ağ (network) ve volume tanımlarını kolayca yapar.

-

Genelde geliştirme ve test ortamlarında tercih edilir, prod ortamında ise Kubernetes gibi orkestrasyon araçlarına geçilir.

Örnek docker-compose.yml

Basit bir Django + Postgres uygulamasını düşünelim:

version: "3.9" # Compose dosyası sürümünü belirtir.

services:

web: # 1.servis (Web Servis)

build: . # (Bulunduğun klasördeki `Dockerfile` kullanılarak imaj üretilir)

ports:

- "8000:8000" # 8000 portuna yönlendirme

depends_on: # Bu servis çalışmadan önce `db` servisinin ayağa kalkmasını garanti eder.

- db

environment:

- DATABASE_URL=postgres://postgres:secret@db:5432/appdb

networks:

- my_network # Manuel network ataması

db: # 2.servis (PostgreSQL veritabanı)

image: postgres:16

environment:

POSTGRES_USER: postgres

POSTGRES_PASSWORD: secret

POSTGRES_DB: appdb

volumes:

- db_data:/var/lib/postgresql/data

networks:

- my_network # Manuel network ataması

volumes:

db_data:

networks: # Manuel network tanımı

my_network:

driver: bridge # Bridge network tipi (en yaygın)

Temel Komutlar

docker compose up→ YAML’deki tüm servisleri ayağa kaldırır.docker compose down→ Tüm servisleri ve network’ü kapatır.docker compose ps→ Compose ile açılan konteynerleri listeler.docker compose logs -f→ Servislerin loglarını canlı izlersin.docker compose exec web bash→ Web konteynerine girip komut çalıştırırsın.

2.5 Docker Desktop (Windows/macOS için)

Docker, Linux üzerinde doğrudan kernel üzerinde çalışabilir. Ancak Windows veya macOS üzerinde bu mümkün değildir çünkü Docker Linux çekirdeği (kernel) gerektirir. İşte bu yüzden Docker Desktop devreye girer.

Docker Desktop Nedir?

-

Docker Desktop, Windows ve macOS kullanıcıları için Docker’ın resmi uygulamasıdır.

-

Linux çekirdeği üzerinde Docker çalıştırabilmek için içinde hafif bir sanal makine (VM) barındırır.

-

Kullanıcıya bu süreci şeffaf bir şekilde sunar: sanki Docker Linux üzerinde çalışıyormuş gibi komutlar yazarsın.

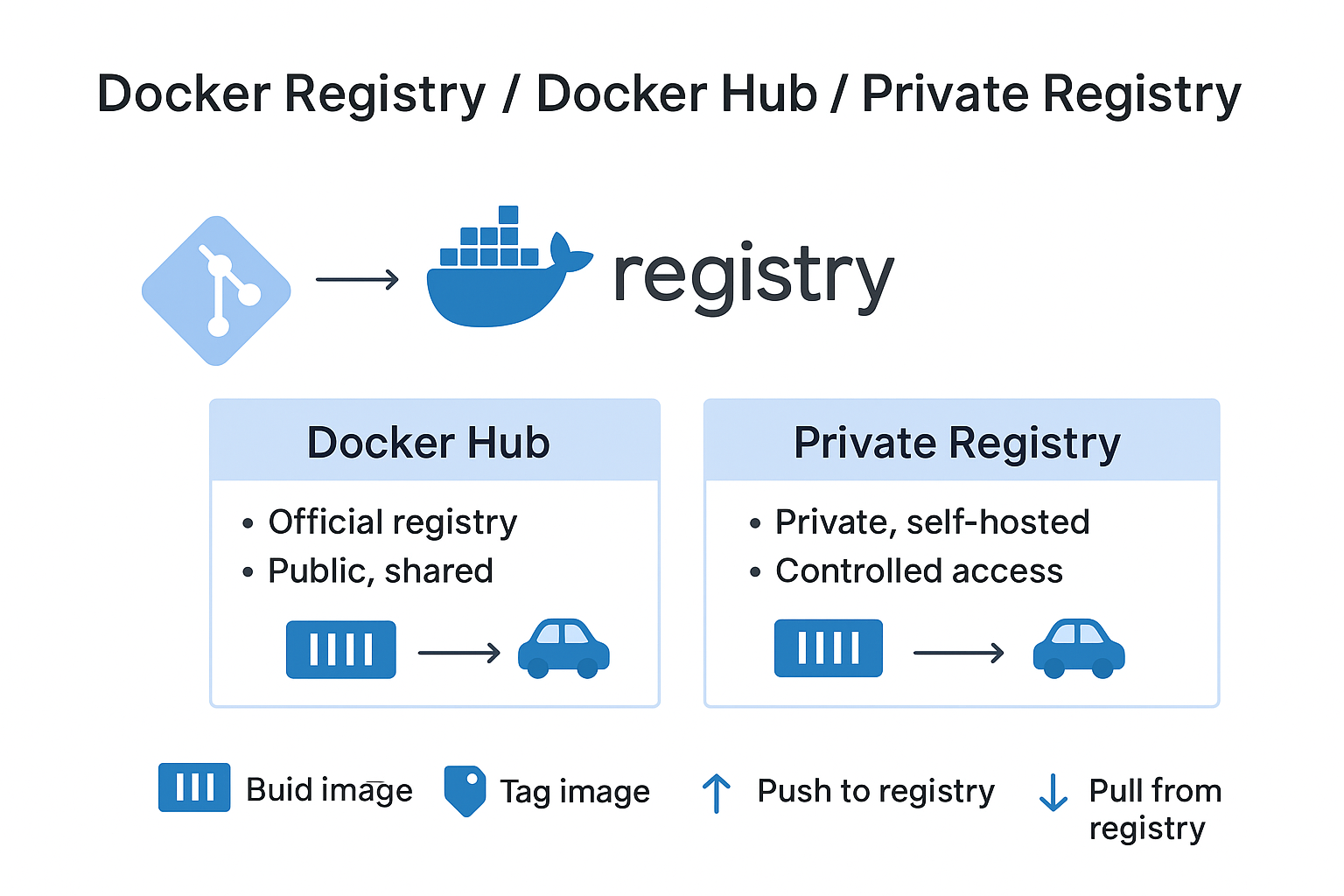

2.6 Docker Registry / Docker Hub / private registry

Docker Registry, Docker imajlarının depolandığı ve paylaşıldığı sunucu veya servisdir. İmajlar, bir Registry üzerinde tutulur ve ihtiyaç duyulduğunda buradan çekilir (pull) veya yüklenir (push).

Docker ekosisteminde en yaygın kullanılan registry türleri Docker Hub ve Private Registry’dir.

Docker Hub

-

Docker’ın resmi registry servisidir.

-

hub.docker.com üzerinden milyonlarca hazır imaj erişilebilir. (nginx, mysql, redis vb.)

-

Avantajları:

- Kolay erişim, büyük topluluk desteği

- Resmi imajlar güvenlik güncellemeleriyle desteklenir

- Ücretsiz plan ile sınırlı kullanıma imkan verir

Kullanım örneği:

docker pull nginx:latest # Docker Hub’dan nginx imajını çek

docker run -d -p 80:80 nginx:latest

Private Registry

-

Şirket içi veya özel projeler için kendi registry’ni kurabilirsin.

-

Örneğin, hassas bir uygulamanın imajlarını yalnızca kendi ağında saklamak isteyebilirsin.

-

Avantajları:

- Tam kontrol (erişim, güvenlik, depolama)

- Gizlilik ve özel dağıtım

-

Kurulum örneği:

docker run -d -p 5000:5000 --name registry registry:2

Bu komut ile yerel bir registry ayağa kalkar.

Artık imajlarını kendi registry’ne push/pull edebilirsin.

Örnek:

docker tag myapp localhost:5000/myapp:latest

docker push localhost:5000/myapp:latest

docker pull localhost:5000/myapp:latest

Registry Kullanım Workflow’u

- İmaj oluştur (

docker build) - İmaj etiketle (

docker tag) - Registry’ye yükle (

docker push) - Registry’den çek (

docker pull)

Docker Hub ile Private Registry kısaca karşılaştırmamız gerekirse:

| Tür | Avantajlar | Dezavantajlar |

|---|---|---|

| Docker Hub | Hazır imajlar, kolay erişim, ücretsiz plan | Özel imajlarda güvenlik, erişim kontrolü sınırlı |

| Private Registry | Gizlilik, tam kontrol, özel dağıtım | Kurulum ve bakım gerektirir |

2.7 Docker Swarm (native orchestration)

Docker Swarm, Docker’ın kendi içinde gelen, birden çok bilgisayarda çalışan konteynerleri tek bir sistem gibi yönetmemizi sağlayan bir özelliktir. Yani:

- Normalde Docker’ı tek bir bilgisayarda çalıştırırsın.

- Eğer yüzlerce konteyneri farklı bilgisayarlarda çalıştırmak istersen, bunu manuel yapmak çok zor olur.

- Docker Swarm, bu işi otomatikleştirir: konteynerleri hangi bilgisayarda çalıştıracağını, kaç tane çalışacağını ve birbirleriyle nasıl konuşacağını kendisi yönetir.

Bir benzetme yapalım:

Docker Swarm, bir orkestra şefi gibidir.

- Tek bir müzisyen (bilgisayar) yerine, birden çok müzisyen (bilgisayar) vardır.

- Şef (Swarm) herkese ne çalacağını, ne zaman çalacağını ve nasıl uyum içinde çalışacaklarını söyler.

- Ortaya düzgün bir müzik (çalışan sistem) çıkar.

Docker Swarm’un Temel Özellikleri

-

Cluster Yönetimi

Birden çok Docker host’unu tek bir sanal Docker host gibi yönetir.

Bu host’lara “node” denir. -

Yük Dengeleme (Load Balancing)

Swarm, servis taleplerini otomatik olarak uygun node’lara yönlendirir. -

Servis Keşfi (Service Discovery)

Swarm, servisleri otomatik olarak birbirine tanıtır.

Servis isimleri üzerinden erişim sağlanabilir. -

Otomatik Failover

Bir node arızalanırsa, Swarm konteynerleri otomatik olarak başka node’lara taşır.

Docker Swarm Yapısı

Swarm cluster’ı iki tip node’dan oluşur:

-

Manager Node

-

Cluster yönetimini üstlenir.

-

Servis dağıtımı, cluster durum kontrolü ve yük dengeleme işlemlerini yapar.

-

-

Worker Node

- Manager node’dan aldığı görevleri çalıştırır.

Docker Swarm Kullanım Örneği

1. Swarm başlatma (manager node)

docker swarm init

Bu komut ile mevcut Docker host, Swarm cluster’ının manager node’u olur.

2. Node ekleme (worker node)

docker swarm join --token <token> <manager-ip>:2377

Bu komut, worker node’u cluster’a ekler. <token> ve <manager-ip> Swarm tarafından sağlanır.

3. Servis oluşturma

docker service create --name myweb --replicas 3 -p 80:80 nginx

-

--replicas 3: Servis için 3 konteyner kopyası çalıştırır. -

-p 80:80: Port yönlendirmesi yapar.

4. Servis durumu kontrolü

docker service ls

docker service ps myweb

Özetle Docker Swarm, küçük ve orta ölçekli projelerde basit, hızlı ve yerleşik bir orkestrasyon çözümüdür.

Kubernetes gibi daha karmaşık sistemlere geçmeden önce hızlı prototipler ve küçük cluster’lar için idealdir.

| Avantajlar | Dezavantajlar |

|---|---|

| Docker ekosistemine entegre, ekstra kurulum gerektirmez | Kubernetes kadar kapsamlı değil |

| Basit yapılandırma | Büyük ölçekli altyapılarda sınırlı özellikler |

| Servis dağıtımı ve otomatik ölçekleme | |

| Load balancing ve service discovery dahili olarak sağlanır |

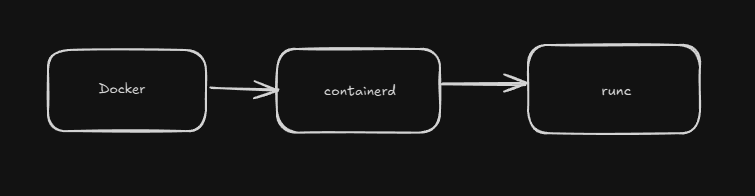

2.8 containerd / runc (altyapı) — kısa not

Docker çalışırken aslında birden fazla katmanda işler yürütülür.

containerd ve runc, Docker’ın en temel altyapı bileşenlerindendir.

containerd

- Docker’ın konteyner yaşam döngüsünü yöneten yüksek seviyeli runtime’ıdır.

- Konteyner oluşturma, çalıştırma, durdurma, silme gibi görevleri yönetir.

- Görüntü (image) yönetimi, network, storage ve konteyner lifecycle gibi işlemler containerd üzerinden yapılır.

runc

- containerd tarafından kullanılan düşük seviyeli runtime’dır.

- Open Container Initiative (OCI) standardına uygun olarak konteynerleri çalıştırır.

- Temel olarak Linux çekirdeği üzerinde konteynerlerin çalışmasını sağlar.

Özetle:

- containerd → Docker’ın konteyner yönetim motoru

- runc → Konteynerleri çekirdek üzerinde çalıştıran motor

Bu ikisi Docker’ın “motoru” gibidir; Docker CLI ise “direksiyon” görevindedir.

3. Kurulum & İlk Adımlar (Linux vs Windows)

Docker kurulumu işletim sistemine göre farklılık gösterir. Bu bölümde Linux ve Windows üzerinde kurulum adımlarını açıklayacağız.

3.A Linux (alt dağıtımlar: Ubuntu/Debian, RHEL/CentOS, Arch)

Docker’ı Linux üzerinde kurarken genellikle şu adımlar uygulanır:

- Paket deposu ekleme → Docker’ın resmi paket deposunu sisteme ekleriz.

- GPG anahtarı ekleme → Paket bütünlüğünü doğrulamak için gerekli.

- Docker ve containerd kurulumu → Docker Engine’i ve container runtime’ını kurarız.

- Docker servisini aktif etme → Sistem başlatıldığında Docker’ın çalışmasını sağlar.

- Kullanıcı yetkilendirmesi → Docker komutlarını root olmadan çalıştırabilmek için kullanıcıyı docker grubuna ekleriz.

Temel komutlar (Ubuntu örneği)

sudo apt update

sudo apt install -y ca-certificates curl gnupg lsb-release

# Docker’ın GPG anahtarını ekleme

curl -fsSL https://download.docker.com/linux/ubuntu/gpg | sudo gpg --dearmor -o /usr/share/keyrings/docker-archive-keyring.gpg

# Docker repository ekleme

echo \

"deb [arch=$(dpkg --print-architecture) signed-by=/usr/share/keyrings/docker-archive-keyring.gpg] \

https://download.docker.com/linux/ubuntu $(lsb_release -cs) stable" | sudo tee /etc/apt/sources.list.d/docker.list > /dev/null

sudo apt update

# Docker Engine, CLI, containerd ve Compose kurulumu

sudo apt install -y docker-ce docker-ce-cli containerd.io docker-compose-plugin

# Docker servisini aktif etme

sudo systemctl enable --now docker

# Kullanıcıyı docker grubuna ekleme (root olmadan docker kullanımı)

sudo usermod -aG docker $USER

Açıklama:

systemctl enable --now docker: Docker servisini etkinleştirir ve anında başlatır.sudo usermod -aG docker $USER: Kullanıcıyı docker grubuna ekler, böylece her komut içinsudogerekmez (çıkış yapıp tekrar giriş yapmak gerekir).

3.B Windows (Docker Desktop + WSL2 ve Windows konteynerler)

Windows üzerinde Docker çalıştırmak için Docker Desktop kullanılır. Docker Desktop, Windows üzerinde Docker’ı çalıştırmak için WSL2 (Windows Subsystem for Linux) veya Hyper-V teknolojilerini kullanır.

Kurulum Aşamaları

1. Docker Desktop Kurulumu

-

Docker Desktop’ı resmi siteden indir.

-

Kurulum sırasında WSL2 entegrasyonu seçeneğini işaretle.

2. WSL2 Kontrolü ve Kurulumu

PowerShell üzerinde:

wsl --list --verbose

Eğer WSL2 kurulu değilse:

wsl --install -d Ubuntu

Bu komut Ubuntu’yu WSL2 üzerinde kurar ve çalıştırır.

3. Hyper-V ve Containers Özelliklerini Etkinleştirme

Docker Desktop’ın düzgün çalışması için Hyper-V ve Containers özellikleri aktif olmalıdır.

PowerShell üzerinde:

dism.exe /online /enable-feature /featurename:Microsoft-Hyper-V /all

dism.exe /online /enable-feature /featurename:Containers /all

4. Docker Desktop’ı Başlatma

- Kurulum tamamlandığında Docker Desktop’ı çalıştır.

- Settings → General bölümünde “Use the WSL 2 based engine” seçeneğini işaretle.

5. Windows Konteynerler vs Linux Konteynerler

Docker Desktop’ta konteyner türünü değiştirebilirsin:

- Linux containers → Varsayılan, çoğu uygulama için önerilen.

- Windows containers → Windows tabanlı uygulamalar için kullanılır.

4. Dockerfile — Adım Adım (Linux ve Windows tabanlı örnekler)

Dockerfile, Docker imajlarının nasıl oluşturulacağını tanımlayan metin dosyasıdır. Bir Docker imajı, bu dosyadaki yönergelere göre adım adım inşa edilir. Dockerfile yazmak, uygulamanın çalışacağı ortamı standartlaştırmak ve dağıtım sürecini kolaylaştırmak için kritik bir adımdır.

Bu bölümde Dockerfile’ın temel direktiflerini, multi-stage build yaklaşımını ve Windows container’larda Dockerfile kullanımını detaylı şekilde ele alacağız.

4.1 Dockerfile Temel Direktifler

Dockerfile içinde kullanılan temel direktifler:

| Direktif | Açıklama |

|---|---|

FROM |

Base image’i tanımlar. |

WORKDIR |

Çalışma dizinini belirler. |

COPY / ADD |

Dosya/dizin kopyalama işlemleri için kullanılır. |

RUN |

Konteyner içinde komut çalıştırır. |

CMD |

Konteyner çalıştırıldığında varsayılan komutu belirler. |

ENTRYPOINT |

CMD ile birlikte çalışır, komutun sabit kısmını tanımlar. |

ENV |

Ortam değişkenlerini tanımlar. |

EXPOSE |

Dinlenecek portu belirtir. |

USER |

Konteynerde çalışacak kullanıcıyı belirtir. |

Not: Direktiflerin sırası, Docker cache mekanizması açısından önemlidir.

4.2 Multi-Stage Builds — Neden, Nasıl?

Multi-stage build, imaj boyutunu azaltmak ve gereksiz bağımlılıkları final imajdan çıkarmak için kullanılır.

Örnek: Node.js Multi-Stage Build

# Stage 1: Build

FROM node:18-alpine AS build

WORKDIR /app

COPY package*.json ./

RUN npm ci

COPY . .

RUN npm run build

# Stage 2: Production

FROM node:18-alpine

WORKDIR /app

COPY --from=build /app/dist ./dist

COPY package*.json ./

RUN npm ci --only=production

CMD ["node", "dist/index.js"]

4.3 Windows Container Dockerfile

Windows container’lar, Linux container’lara göre farklı Dockerfile direktifleri ve base image’lar kullanır.

Örnek: Windows PowerShell Base Image

FROM mcr.microsoft.com/windows/servercore:ltsc2022

SHELL ["powershell", "-Command", "$ErrorActionPreference = 'Stop';"]

RUN Write-Host 'Hello from Windows container'

CMD ["powershell.exe"]

Ek Bilgi: Windows container imajları genellikle Linux’a göre daha büyük boyutludur.

4.4 Örnek: Linux Node.js Dockerfile

FROM node:18-alpine

WORKDIR /app

COPY package*.json ./

RUN npm ci --only=production

COPY . .

USER node

CMD ["node", "index.js"]

4.5 İyi Pratikler

Dockerfile yazarken katman sayısını azaltmak için RUN komutlarını birleştirmeli, .dockerignore ile gereksiz dosyaları build sürecinden çıkarmalı, küçük base image’ler (Alpine, distroless vb.) tercih etmeli, multi-stage build kullanmalı ve ortam değişkenlerini ENV direktifiyle yönetmelisiniz.

Özetle:

- Katman sayısını azaltmak için RUN komutlarını birleştirin.

.dockerignoreile gereksiz dosyaları build sürecinden çıkarın.- Küçük base image seçin (Alpine, distroless vb.).

- Multi-stage build kullanın.

- Ortam değişkenlerini ENV ile yönetin.

4.6 Dockerfile Optimizasyonu

Dockerfile optimizasyonu, build süresini kısaltır, imaj boyutunu küçültür ve dağıtım sürecini hızlandırır.

Temel optimizasyon teknikleri:

- Cache kullanımını iyi yönetmek: Direktiflerin sırasını mantıklı tutmak (

COPY package*.json→RUN npm ci→COPY . .gibi). - Katman sayısını azaltmak: RUN komutlarını zincirlemek (

&&ile). - Küçük base image kullanmak: Alpine, distroless veya slim image’lar.

- .dockerignore dosyası oluşturmak: Gereksiz dosyaları dışarıda bırakmak.

- Multi-stage build kullanmak: Gereksiz bağımlılıkları final imajdan çıkarmak.

4.7 Best Practices ve Performans İpuçları

COPYkomutlarını minimumda tutun.- Ağ üzerinden dosya indirmeleri için

RUN curl/wgetyerine build argümanlarını kullanın. - Gereksiz paketleri kaldırın (

apt-get clean,rm -rf /var/lib/apt/lists/*). - Build sürecinde mümkünse

--no-cacheseçeneğini test amaçlı kullanın. - Ortam değişkenleri ile konfigürasyonu yönetin, hard-code etmeyin.

4.8 Özet ve İleri Okuma

Dockerfile, konteyner tabanlı uygulama geliştirme sürecinde en kritik parçadır. İyi bir Dockerfile:

- Hızlı build olur,

- Küçük boyutlu imaj üretir,

- Kolay bakım sağlar.

İleri Okuma için Kaynaklar:

- Dockerfile Reference — Docker Docs

- Best Practices for Writing Dockerfiles

- Multi-Stage Builds — Docker Docs

5. Image Yönetimi ve Optimizasyon

Docker imajları, uygulamanızın çalışması için gerekli tüm dosya, bağımlılık ve konfigürasyonu içerir. Etkili imaj yönetimi, hem depolama alanını hem de konteyner başlatma süresini doğrudan etkiler. Bu bölümde imaj yönetiminin temellerini ve optimizasyon tekniklerini ele alacağız.

5.1 Layer Mantığı ve Cache Mekanizması

Docker imajları layer (katman) yapısına dayanır. Her Dockerfile satırı bir katman oluşturur. Bu katmanlar, build sürecinde yeniden kullanılabilir. Bu sayede:

- İmaj oluşturma süresi kısalır,

- Disk kullanımı azalır.

Önemli nokta: Katmanların yeniden kullanılabilmesi için Dockerfile’da yapılan değişiklikler minimum olmalıdır.

5.2 .dockerignore, Katman Sayısını Azaltma, Küçük Base Image Seçme

.dockerignoredosyası →.gitignoregibi çalışır; build sırasında gereksiz dosyaların konteynere eklenmesini engeller.- Katman sayısını azaltma → Gereksiz RUN komutlarını birleştirerek katman sayısını düşürmek, imaj boyutunu azaltır.

- Küçük base image seçme →

alpine,busyboxgibi minimal base imajlar, gereksiz bağımlılıkları ortadan kaldırarak imaj boyutunu ciddi şekilde küçültür.

5.3 Önemli Image Yönetimi Komutları

docker build --no-cache→ Katman önbelleğini kullanmadan imaj oluşturur.docker history <image>→ İmajın layer geçmişini gösterir.docker image prune→ Kullanılmayan imajları temizler.

Örnekler:

docker build --no-cache -t myapp:latest .

docker history myapp:latest

docker image prune -a

5.4 Multi-Arch ve docker buildx

Modern uygulamalar farklı platformlarda çalışabilir. Multi-arch (çoklu mimari) imajlar, tek build ile farklı CPU mimarilerine uygun imajlar oluşturmayı sağlar.

docker buildx, Docker’ın gelişmiş build özelliğidir ve multi-arch imajlar için kullanılır.

Örnek:

docker buildx create --use

docker buildx build --platform linux/amd64,linux/arm64 -t myapp:multiarch .

Bu komut ile amd64 ve arm64 mimarileri için tek seferde imaj oluşturulur.

6. Volumes ve Storage (Linux vs Windows farkları)

Docker’da konteynerler geçici ortamlardır — konteyner silindiğinde içindeki tüm veriler kaybolur. Bu nedenle verilerin kalıcılığını sağlamak için volumes ve farklı storage yöntemleri kullanılır. Ancak Linux ve Windows arasında mount yolları, izinler ve davranışlar farklıdır.

Bu bölümde:

- Named volumes, bind mounts ve tmpfs’in farklarını,

- SELinux ile ilgili izin etiketlerini,

- Windows’ta yol yazımı ve izin farklarını,

- Volume yedekleme ve geri yükleme yöntemlerini detaylıca öğreneceksiniz.

6.1 Named Volumes vs Bind Mounts vs tmpfs

Docker’da veri kalıcılığı için üç ana yöntem vardır:

| Tür | Açıklama | Kullanım Durumu |

|---|---|---|

| Named Volumes | Docker tarafından yönetilen, konteynerler arası paylaşılabilen ve kalıcı veri depolama alanları. | Veri saklama, veri paylaşımı, veri yedekleme. |

| Bind Mounts | Host makinedeki belirli bir dizini konteynere bağlama yöntemi. | Geliştirme sürecinde kod paylaşımı, konfigürasyon dosyaları. |

| tmpfs | RAM üzerinde çalışan geçici depolama. Kalıcı değildir, konteyner kapandığında silinir. | Geçici veriler, hız gerektiren işlemler, güvenlik açısından RAM üzerinde çalışma. |

Named Volume Örneği

docker volume create mydata

docker run -d -v mydata:/app/data myimage

docker volume createkomutu volume oluşturur./app/dataiçinde konteyner verisi kalıcı olur.- Container silinse bile volume içeriği korunur.

Bind Mount Örneği

Linux:

docker run -v /home/me/app:/app myimage

Windows (PowerShell):

docker run -v "C:\Users\Me\app":/app myimage

- Bind mount, host sistemi ile konteyner arasında doğrudan dosya paylaşımı sağlar.

- Kod geliştirme ve test süreçlerinde sık kullanılır.

tmpfs Örneği

docker run --tmpfs /app/tmp:rw,size=100m myimage

/app/tmpgeçici olarak RAM’de tutulur.- Konteyner kapandığında veriler kaybolur.

- Performans kritik işlemler için uygundur.

6.2 SELinux :z / :Z Etiketi Linux’ta Neden Gereklidir

SELinux güvenlik politikaları, bind mount’ların konteyner içinde kullanılabilmesi için ek etiketler gerektirir.

Bu etiketler mount edilen dizinin izinlerini belirler:

:z→ Mount edilen dizinin paylaşılması için genel erişim izni sağlar.:Z→ Mount edilen dizinin yalnızca ilgili konteyner için erişim izni olmasını sağlar.

Örnek:

docker run -v /home/me/app:/app:Z myimage

SELinux etkin olan sistemlerde bu etiketleri kullanmazsanız bind mount çalışmaz veya izin hataları alırsınız.

6.3 Windows’ta Yol Yazımı ve İzin Farklılıkları

Windows’ta bind mount’larda yol yazımı ve izinler Linux’tan farklıdır. Windows’ta bind mount kullanırken dikkat edilmesi gerekenler:

- Yol formatı PowerShell için çift tırnak içinde olmalıdır.

\yerine/kullanılabilir, ancak"C:\path\to\dir"formatı güvenlidir.- Windows ACL izinleri bind mount’larda etkili olabilir, bu yüzden izinleri kontrol etmek gerekir.

Örnek Bind Mount:

Linux:

docker run -v /home/me/app:/app myimage

Windows (PowerShell):

docker run -v "C:\Users\Me\app":/app myimage

6.4 Yedekleme / Geri Yükleme: tar ile Volume Yedekleme Yöntemi

Docker volume’larını yedeklemek veya geri yüklemek için tar komutu kullanılabilir. Bu yöntem hem Linux hem Windows için uygundur.

Yedekleme

docker run --rm -v myvolume:/volume -v $(pwd):/backup alpine \

tar czf /backup/myvolume-backup.tar.gz -C /volume .

Açıklama:

--rm→ Container durduğunda otomatik silinir.-v myvolume:/volume→ Yedeklenecek volume bağlanır.-v $(pwd):/backup→ Host dizini bağlanır, yedekleme dosyası buraya kaydedilir.tar czf→ Verileri sıkıştırarak.tar.gzformatında yedekler.

Geri Yükleme

docker run --rm -v myvolume:/volume -v $(pwd):/backup alpine \

tar xzf /backup/myvolume-backup.tar.gz -C /volume

Geri yükleme öncesinde volume’ın boş olduğundan emin olun. Aksi halde eski veriler üzerine yazılır.

7. Ağ (Networking)

Docker’da ağ yönetimi, konteynerlerin birbirleriyle ve host sistemiyle iletişim kurabilmesini sağlar. Docker, varsayılan olarak konteynerler arasında izolasyon sağlar ve farklı ağ modları sunar. Ağlar, Docker’ın en kritik kavramlarından biridir, çünkü uygulamaların güvenliği, ölçeklenebilirliği ve yönetilebilirliği doğrudan ağ yapılandırmasına bağlıdır.

Bu bölümde:

- Docker’ın varsayılan ağ modlarını,

- Custom bridge network oluşturmayı,

- Container içi DNS ve servis keşfini,

- Host networking modunu ve kısıtlarını,

- Overlay, macvlan ve transparent network yapılarını ele alacağız.

7.1 Default Bridge ve Custom Bridge Oluşturma

Docker kurulduğunda otomatik olarak bir default bridge ağı oluşturur.

Bu ağ üzerinde konteynerler, IP adresleri üzerinden birbirlerini görebilir, ancak host ile iletişim için port yönlendirme gerekir.

Default Bridge Örneği:

docker run -d --name web -p 8080:80 nginx

-p 8080:80 → Host’un 8080 portunu container’ın 80 portuna yönlendirir.

Custom Bridge Oluşturma

Custom bridge ağlar, izolasyon ve servis keşfi için daha esnek yapı sağlar.

Ağ oluşturma:

docker network create mynet

Container’ı custom bridge ile başlatma:

docker run -dit --name a --network mynet busybox

docker run -dit --name b --network mynet busybox

Test:

docker exec -it a ping b

( Container a, container b’yi DNS adı ile görebilir.)

7.2 Container İçi DNS ve Servis Keşfi (Compose ile)

Docker Compose, container’lar arasında otomatik DNS çözümlemesi sağlar.

Servis adı, container adı olarak kullanılabilir.

docker-compose.yml Örneği:

version: "3"

services:

web:

image: nginx

networks:

- mynet

app:

image: busybox

command: ping web

networks:

- mynet

networks:

mynet:

( Burada app container’ı, web container’ını DNS ismi üzerinden bulabilir.)

7.3 --network host (Linux’ta) ve Host Networking’in Kısıtları

Host networking modu, container’ın host’un ağ stack’ini paylaşmasını sağlar.

Bu durumda port yönlendirme gerekmez.

Linux örneği:

docker run --network host nginx

hostmodu Linux’ta çalışır ancak Windows/macOS üzerinde Docker Desktop’ta desteklenmez.

Güvenlik açısından

hostmodu dikkatli kullanılmalıdır, çünkü container host ağını doğrudan etkiler.

7.4 Overlay Network (Swarm), macvlan, Transparent Networks (Windows)

Overlay Network (Docker Swarm)

- Farklı host makinelerdeki container’ların birbirleriyle iletişim kurmasını sağlar.

- Docker Swarm cluster’larında kullanılır.

Overlay Network oluşturma:

docker network create -d overlay my_overlay

Macvlan Network

- Container’lara host ağı üzerinde kendi MAC adresini verir.

- Fiziksel ağda ayrı bir cihaz gibi görünmesini sağlar.

Örnek:

docker network create -d macvlan \

--subnet=192.168.1.0/24 \

--gateway=192.168.1.1 \

-o parent=eth0 my_macvlan

Transparent Network (Windows)

- Windows container’larda fiziksel ağ ile doğrudan bağlantı kurmak için kullanılır.

- Genellikle enterprise ağ senaryolarında tercih edilir.

7.5 Örnek: Custom Bridge Network Kullanımı

docker network create mynet

docker run -dit --name a --network mynet busybox

docker run -dit --name b --network mynet busybox

Ping testi:

docker exec -it a ping b

Container’lar aynı custom bridge üzerinde DNS ile birbirlerine ulaşabilir.

7.6 Özet İpuçları

- Default bridge hızlı başlamak için uygundur ama DNS çözümleme özelliği sınırlıdır.

- Custom bridge izolasyon ve DNS desteği sağlar.

- Host networking performans avantajı sağlar ama Linux dışındaki platformlarda sınırlıdır.

- Overlay network multi-host senaryolarında çok kullanışlıdır.

- macvlan ve transparent networks fiziksel ağ entegrasyonu gereken durumlarda tercih edilir.

8. Docker Swarm / Stack (Native Orchestrator)

Docker Swarm, 2.7’de kısa tanıttık. Şimdi gerçek dünya kullanımı için detaylı bir rehber hazırlayalım.

Docker Swarm, Docker’ın yerleşik orkestrasyon aracıdır. Birden fazla sunucuyu (node) tek bir cluster olarak yönetir, konteynerleri otomatik dağıtır, ölçeklendirir ve arıza durumlarında yük dengelemesi yapar.

Ne zaman kullanılır?

- Küçük-orta ölçekli projeler

- Kubernetes’ten daha basit bir yapı isteyenler

- Hızlı prototip ve test ortamları

- Docker’a zaten aşina olan ekipler

Kubernetes ile farkı:

- Swarm daha basit, kurulumu ve yönetimi kolay

- Kubernetes daha güçlü ama karmaşık

- Swarm, Docker ekosistemiyle tam entegre

8.1 Swarm Cluster Kurulumu ve Servis Yönetimi

8.1.1 Swarm Başlatma (docker swarm init)

Manager Node Kurulumu:

docker swarm init --advertise-addr 192.168.1.10

Açıklama:

--advertise-addr: Bu node’un IP adresi. Diğer node’lar bu IP üzerinden bağlanacak.- Komut çalıştıktan sonra bir join token verir.

Çıktı örneği:

Swarm initialized: current node (abc123) is now a manager.

To add a worker to this swarm, run the following command:

docker swarm join --token SWMTKN-1-xxxxx 192.168.1.10:2377

8.1.2 Worker Node Ekleme

Worker node’da şu komutu çalıştır:

docker swarm join --token SWMTKN-1-xxxxx 192.168.1.10:2377

Node’ları kontrol etme (manager’da):

docker node ls

Çıktı:

ID HOSTNAME STATUS AVAILABILITY MANAGER STATUS

abc123 * node1 Ready Active Leader

def456 node2 Ready Active

8.1.3 Servis Oluşturma (docker service create)

Basit bir web servisi:

docker service create \

--name myweb \

--replicas 3 \

--publish 80:80 \

nginx:alpine

Parametreler:

--name: Servis adı--replicas: Kaç konteyner kopyası çalışacak--publish: Port yönlendirme (host:container)

Servis durumunu kontrol:

docker service ls

docker service ps myweb

Çıktı:

ID NAME IMAGE NODE DESIRED STATE CURRENT STATE

abc1 myweb.1 nginx:alpine node1 Running Running 2 mins

abc2 myweb.2 nginx:alpine node2 Running Running 2 mins

abc3 myweb.3 nginx:alpine node1 Running Running 2 mins

8.1.4 Servis Güncelleme

Image güncelleme:

docker service update --image nginx:latest myweb

Replika sayısını değiştirme:

docker service scale myweb=5

Port ekleme:

docker service update --publish-add 8080:80 myweb

8.1.5 Servis Silme

docker service rm myweb

8.2 Replication, Rolling Update, Constraints, Configs & Secrets

8.2.1 Replication (Çoklama)

Swarm, belirlenen sayıda replika çalıştırır. Bir konteyner çökerse otomatik yenisini başlatır.

Manuel scaling:

docker service scale myweb=10

Otomatik yük dengeleme: Swarm, gelen istekleri tüm replikalara dağıtır.

8.2.2 Rolling Update (Sıfır Kesinti Güncellemesi)

Servisleri kesintisiz güncellemek için rolling update kullanılır.

Örnek: Nginx 1.20’den 1.21’e geçiş

docker service update \

--image nginx:1.21-alpine \

--update-delay 10s \

--update-parallelism 2 \

myweb

Parametreler:

--update-delay: Her güncelleme arasında bekleme süresi--update-parallelism: Aynı anda kaç konteyner güncellenecek

Rollback (Geri alma):

docker service rollback myweb

8.2.3 Constraints (Yerleştirme Kısıtları)

Belirli node’larda servis çalıştırmak için constraint kullanılır.

Örnek: Sadece “production” etiketli node’larda çalışsın

docker service create \

--name prodapp \

--constraint 'node.labels.env==production' \

nginx:alpine

Node’a etiket ekleme:

docker node update --label-add env=production node2

Örnek: Manager node’larda çalıştırma

docker service create \

--name monitoring \

--constraint 'node.role==manager' \

--mode global \

prometheus

8.2.4 Configs (Yapılandırma Dosyaları)

Swarm, hassas olmayan yapılandırma dosyalarını config olarak saklar.

Config oluşturma:

echo "server { listen 80; }" > nginx.conf

docker config create nginx_config nginx.conf

Serviste kullanma:

docker service create \

--name web \

--config source=nginx_config,target=/etc/nginx/nginx.conf \

nginx:alpine

Config’leri listeleme:

docker config ls

8.2.5 Secrets (Şifre Yönetimi)

Secrets, hassas bilgileri (şifreler, API anahtarları) güvenli şekilde saklar.

Secret oluşturma:

echo "myDBpassword" | docker secret create db_password -

Serviste kullanma:

docker service create \

--name myapp \

--secret db_password \

myimage

Konteyner içinde erişim:

cat /run/secrets/db_password

Secret’ler şifrelenir ve sadece yetkili konteynerler erişebilir.

Secret’leri listeleme:

docker secret ls

Secret silme:

docker secret rm db_password

8.3 Compose ile Swarm: Migration (Geçiş)

Docker Compose dosyaları, küçük değişikliklerle Swarm’da kullanılabilir.

8.3.1 Compose’dan Stack’e Geçiş

docker-compose.yml (Development):

version: "3.8"

services:

web:

image: nginx:alpine

ports:

- "80:80"

volumes:

- ./html:/usr/share/nginx/html

depends_on:

- db

db:

image: postgres:15

environment:

POSTGRES_PASSWORD: secret

volumes:

- db_data:/var/lib/postgresql/data

volumes:

db_data:

docker-stack.yml (Production - Swarm):

version: "3.8"

services:

web:

image: nginx:alpine

ports:

- "80:80"

deploy:

replicas: 3

update_config:

parallelism: 1

delay: 10s

restart_policy:

condition: on-failure

networks:

- webnet

db:

image: postgres:15

environment:

POSTGRES_PASSWORD_FILE: /run/secrets/db_password

secrets:

- db_password

volumes:

- db_data:/var/lib/postgresql/data

deploy:

replicas: 1

placement:

constraints:

- node.role == manager

networks:

- webnet

volumes:

db_data:

secrets:

db_password:

external: true

networks:

webnet:

driver: overlay

Farklar:

deploybölümü eklendi (replicas, update_config, placement)depends_onkaldırıldı (Swarm’da çalışmaz)secretskullanıldı- Network driver

overlayolarak değiştirildi

8.3.2 Stack Deploy

Secret oluşturma:

echo "myDBpassword" | docker secret create db_password -

Stack’i deploy etme:

docker stack deploy -c docker-stack.yml myapp

Stack durumunu kontrol:

docker stack ls

docker stack services myapp

docker stack ps myapp

Stack’i kaldırma:

docker stack rm myapp

8.4 Pratik Örnekler

Örnek 1: WordPress + MySQL Stack

stack.yml:

version: "3.8"

services:

wordpress:

image: wordpress:latest

ports:

- "8080:80"

environment:

WORDPRESS_DB_HOST: db

WORDPRESS_DB_USER: wordpress

WORDPRESS_DB_PASSWORD_FILE: /run/secrets/db_password

WORDPRESS_DB_NAME: wordpress

secrets:

- db_password

deploy:

replicas: 2

networks:

- wpnet

db:

image: mysql:8

environment:

MYSQL_ROOT_PASSWORD_FILE: /run/secrets/db_password

MYSQL_DATABASE: wordpress

MYSQL_USER: wordpress

MYSQL_PASSWORD_FILE: /run/secrets/db_password

secrets:

- db_password

volumes:

- db_data:/var/lib/mysql

deploy:

replicas: 1

placement:

constraints:

- node.role == manager

networks:

- wpnet

volumes:

db_data:

secrets:

db_password:

external: true

networks:

wpnet:

driver: overlay

Deploy:

echo "mySecretPassword123" | docker secret create db_password -

docker stack deploy -c stack.yml wordpress

Örnek 2: Load Balancer + API

version: "3.8"

services:

nginx:

image: nginx:alpine

ports:

- "80:80"

configs:

- source: nginx_config

target: /etc/nginx/nginx.conf

deploy:

replicas: 1

networks:

- frontend

api:

image: myapi:latest

deploy:

replicas: 5

update_config:

parallelism: 2

delay: 10s

networks:

- frontend

configs:

nginx_config:

external: true

networks:

frontend:

driver: overlay

8.5 Swarm Komutları Özet

| Komut | Açıklama |

|---|---|

docker swarm init |

Swarm cluster başlat |

docker swarm join |

Worker node ekle |

docker node ls |

Node’ları listele |

docker service create |

Servis oluştur |

docker service ls |

Servisleri listele |

docker service ps <service> |

Servis detayları |

docker service scale <service>=N |

Replika sayısını değiştir |

docker service update |

Servis güncelle |

docker service rollback |

Önceki versiyona dön |

docker stack deploy |

Stack deploy et |

docker stack ls |

Stack’leri listele |

docker stack rm |

Stack’i kaldır |

docker secret create |

Secret oluştur |

docker config create |

Config oluştur |

8.6 Özet ve İleri Okuma

Docker Swarm, kolay kurulum ve yönetim sunar. Kubernetes’e geçmeden önce ideal bir orkestrasyon çözümüdür.

Avantajları:

- Docker ile tam entegre

- Basit komutlar

- Hızlı kurulum

- Yerleşik load balancing

Dezavantajları:

- Büyük ölçekli projelerde Kubernetes kadar güçlü değil

- Topluluk desteği daha az

Ne zaman kullanılır?

- 10-50 node arası cluster’lar

- Hızlı prototipleme

- Docker’a aşina ekipler

İleri Okuma:

9. Kubernetes ile Karşılaştırma

Docker Swarm’ı öğrendikten sonra orkestrasyon araçları arasındaki farkları anlamak önemlidir. Bu bölümde Docker Compose, Swarm ve Kubernetes’in teknik karşılaştırmasını yapacağız ve hangi senaryoda hangi aracın tercih edilmesi gerektiğini inceleyeceğiz.

9.1 Orkestrasyon Araçlarının Genel Bakışı

Docker ekosisteminde üç temel orkestrasyon yaklaşımı bulunur. Docker Compose tek sunucuda birden fazla konteyneri yönetirken, Docker Swarm birden fazla sunucuyu cluster olarak yönetir ve Kubernetes ise büyük ölçekli, karmaşık sistemler için tasarlanmış güçlü bir orkestrasyon platformudur.

Her birinin farklı kullanım senaryoları ve karmaşıklık seviyeleri vardır. Docker Compose geliştirme ortamları için idealdir, Docker Swarm küçük ve orta ölçekli production ortamları için yeterlidir, Kubernetes ise büyük ölçekli ve karmaşık sistemler için en uygun seçenektir.

Kullanım Alanları ve Ölçek

| Araç | Sunucu Sayısı | Kullanım Alanı | Karmaşıklık |

|---|---|---|---|

| Docker Compose | 1 sunucu | Geliştirme, test ortamları | Düşük |

| Docker Swarm | 2-50 sunucu | Küçük-orta production | Orta |

| Kubernetes | 10+ sunucu | Büyük ölçekli production | Yüksek |

9.2 Teknik Özellik Karşılaştırması

Her üç aracın da farklı teknik özellikleri ve yetenekleri vardır. Kurulum süresi, öğrenme eğrisi, ölçekleme yetenekleri ve diğer önemli özellikler aşağıdaki tabloda karşılaştırılmıştır.

| Özellik | Docker Compose | Docker Swarm | Kubernetes |

|---|---|---|---|

| Kurulum | Tek komut | 5 dakika | Saatler |

| Öğrenme Süresi | 1 gün | 1 hafta | 1-3 ay |

| Ölçekleme | Manuel | Otomatik (basit) | Otomatik (gelişmiş) |

| Load Balancing | Harici araç gerekli | Yerleşik | Yerleşik + gelişmiş |

| Self-Healing | Yok | Var | Gelişmiş |

| Rolling Update | Manuel | Var | Gelişmiş (canary, blue-green) |

| Multi-Host | Desteklenmez | Desteklenir | Desteklenir |

| Secrets | Environment variables | Docker secrets | Kubernetes secrets + vault |

| Monitoring | Harici | Harici | Prometheus entegrasyonu |

| Cloud Desteği | Yok | Sınırlı | EKS, GKE, AKS |

Docker Compose’un en büyük avantajı basitliğidir ancak tek sunucu ile sınırlıdır. Docker Swarm, Docker CLI ile tam entegre çalışır ve Compose dosyalarıyla uyumludur. Kubernetes ise en güçlü özelliklere sahip olmakla birlikte en karmaşık yapıya sahiptir.

9.3 Avantajlar ve Dezavantajlar

Docker Compose

Docker Compose, yerel geliştirme ve tek sunuculu uygulamalar için tasarlanmış basit bir araçtır. YAML dosyası son derece okunabilir ve anlaşılır bir yapıya sahiptir. Tek bir komutla tüm sistemi ayağa kaldırabilir, geliştirme sürecini hızlandırır. Öğrenmesi çok kolaydır ve hızlı prototipleme için idealdir.

Ancak bazı önemli sınırlamaları vardır. Tek sunucu ile sınırlı olduğu için büyüyen projeler için uygun değildir. Otomatik ölçekleme özelliği yoktur ve load balancing işlemleri manuel olarak yapılmalıdır. Production ortamları için yetersizdir ve multi-host desteği bulunmamaktadır.

| Avantajlar | Dezavantajlar |

|---|---|

| YAML dosyası basit ve okunabilir | Tek sunucu sınırlaması |

| Tek komutla sistem ayağa kalkar | Otomatik ölçekleme yok |

| Yerel geliştirme için ideal | Production için yetersiz |

| Hızlı prototipleme | Load balancing manuel |

| Öğrenmesi çok kolay | Multi-host desteği yok |

Uygun Olduğu Durumlar: Geliştirme ortamları, tek sunuculu uygulamalar, MVP ve prototip projeler için idealdir.

Docker Swarm

Docker Swarm, Docker ekosisteminin doğal bir parçası olarak tasarlanmıştır. Docker CLI ile tam entegre çalışır ve mevcut Docker bilginizi kullanarak kolayca öğrenebilirsiniz. Compose dosyalarınızı küçük değişikliklerle Swarm’da kullanabilirsiniz. Kurulumu yaklaşık 5 dakika sürer ve yerleşik load balancing özelliğine sahiptir. Öğrenme eğrisi Kubernetes’e göre çok daha düşüktür.

Bununla birlikte bazı kısıtlamaları vardır. Ölçekleme kapasitesi Kubernetes kadar güçlü değildir. Auto-scaling gibi gelişmiş özellikler basit seviyededir. Topluluk desteği Kubernetes’e göre daha azdır ve cloud provider entegrasyonu sınırlıdır.

| Avantajlar | Dezavantajlar |

|---|---|

| Docker CLI ile tam entegrasyon | Ölçekleme kapasitesi sınırlı |

| Compose dosyalarıyla uyumlu | Gelişmiş özellikler eksik |

| Hızlı kurulum (5 dakika) | Topluluk desteği az |

| Yerleşik load balancing | Cloud entegrasyonu sınırlı |

| Düşük öğrenme eğrisi | Auto-scaling basit seviyede |

Uygun Olduğu Durumlar: 5-50 sunuculu yapılar, Docker bilgisi olan ekipler, orta ölçekli production ortamları ve basit mikroservis mimarileri için uygundur.

Kubernetes

Kubernetes, container orkestrasyon dünyasının en güçlü ve kapsamlı platformudur. HPA (Horizontal Pod Autoscaler) ve VPA (Vertical Pod Autoscaler) gibi güçlü otomatik ölçekleme mekanizmalarına sahiptir. Self-healing yetenekleri sayesinde arızalanan pod’ları otomatik olarak yeniden başlatır. Canary ve blue-green gibi gelişmiş deployment stratejilerini destekler. Çok büyük bir topluluk ve ekosisteme sahiptir. AWS EKS, Google GKE ve Azure AKS gibi tüm büyük cloud provider’lar tarafından tam olarak desteklenir. Istio ve Linkerd gibi service mesh araçlarıyla entegre çalışabilir.

Ancak bu güçlü özellikler bazı maliyetlerle gelir. Kurulum ve yapılandırma karmaşıktır, saatler sürebilir. Öğrenme eğrisi çok diktir, 1-3 ay gibi bir süre gerektirebilir. Master node’lar nedeniyle kaynak tüketimi yüksektir. Yönetim maliyeti ve operasyonel karmaşıklık fazladır. Küçük projeler için aşırı karmaşık bir çözümdür (overkill).

| Avantajlar | Dezavantajlar |

|---|---|

| Güçlü otomatik ölçekleme (HPA, VPA) | Karmaşık kurulum ve yapılandırma |

| Self-healing mekanizmaları | Dik öğrenme eğrisi |

| Gelişmiş deployment stratejileri | Yüksek kaynak tüketimi |

| Büyük topluluk ve ekosistem | Yönetim maliyeti yüksek |

| Cloud provider desteği tam | Küçük projeler için aşırı karmaşık |

| Service mesh entegrasyonu | Master node overhead |

Uygun Olduğu Durumlar: 50+ sunuculu yapılar, karmaşık mikroservis mimarileri, multi-cloud stratejileri ve yüksek trafikli uygulamalar için en uygun seçenektir.

9.4 Compose’dan Kubernetes’e Geçiş

Docker Compose dosyalarınızı Kubernetes’e taşımak için iki yöntem kullanabilirsiniz: otomatik dönüştürme aracı Kompose veya manuel dönüştürme. Kompose aracı, mevcut Compose dosyalarınızı Kubernetes YAML formatına otomatik olarak çevirir.

Kompose Aracı ile Otomatik Dönüştürme

Kompose aracını Linux, macOS veya Windows üzerinde kurabilirsiniz. Linux için curl komutuyla binary dosyayı indirip çalıştırılabilir hale getirmeniz yeterlidir. macOS’ta Homebrew ile, Windows’ta ise Chocolatey ile kurulum yapabilirsiniz.

Kurulum:

# Linux

curl -L https://github.com/kubernetes/kompose/releases/download/v1.31.0/kompose-linux-amd64 -o kompose

chmod +x kompose

sudo mv ./kompose /usr/local/bin/kompose

# macOS

brew install kompose

# Windows

choco install kompose

Kurulum tamamlandıktan sonra mevcut docker-compose.yml dosyanızı dönüştürmek için kompose convert komutunu kullanabilirsiniz. Bu komut, Compose dosyanızı analiz eder ve karşılık gelen Kubernetes Service, Deployment ve PersistentVolumeClaim dosyalarını oluşturur.

Dönüştürme:

kompose convert -f docker-compose.yml

Kompose, her servis için ayrı YAML dosyaları oluşturur. Örneğin bir web servisi için hem Service hem de Deployment dosyası, bir veritabanı için ise ek olarak PersistentVolumeClaim dosyası oluşturulur.

Çıktı:

INFO Kubernetes file "web-service.yaml" created

INFO Kubernetes file "web-deployment.yaml" created

INFO Kubernetes file "db-persistentvolumeclaim.yaml" created

Oluşturulan dosyaları Kubernetes cluster’ınıza deploy etmek için kubectl aracını kullanabilirsiniz. Apply komutu, bulunduğunuz dizindeki tüm YAML dosyalarını okur ve cluster’a uygular.

Deploy:

kubectl apply -f .

Manuel Dönüştürme Örneği

Bazen otomatik dönüştürme yetersiz kalabilir veya daha fazla kontrol isteyebilirsiniz. Bu durumda manuel dönüştürme yapmanız gerekir. Aşağıda basit bir Docker Compose dosyasının Kubernetes eşdeğerine nasıl çevrileceğini görebilirsiniz.

Docker Compose’da bir servisi tanımlamak çok basittir. Image adını, replika sayısını ve port yönlendirmesini belirtmeniz yeterlidir. Ancak Kubernetes’te aynı işlevi gerçekleştirmek için hem Deployment hem de Service nesnesi oluşturmanız gerekir.

Docker Compose:

version: "3.8"

services:

web:

image: nginx:alpine

replicas: 3

ports:

- "80:80"

Kubernetes Deployment objesi, kaç pod çalışacağını, hangi image kullanılacağını ve pod’ların nasıl etiketleneceğini tanımlar. Service objesi ise bu pod’lara dışarıdan erişimi sağlar ve load balancing yapar. LoadBalancer tipi service, cloud provider’dan otomatik olarak bir external IP alır.

Kubernetes Deployment:

apiVersion: apps/v1

kind: Deployment

metadata:

name: web

spec:

replicas: 3

selector:

matchLabels:

app: web

template:

metadata:

labels:

app: web

spec:

containers:

- name: web

image: nginx:alpine

ports:

- containerPort: 80

---

apiVersion: v1

kind: Service

metadata:

name: web

spec:

type: LoadBalancer

ports:

- port: 80

targetPort: 80

selector:

app: web

9.5 Senaryo Bazlı Öneriler

Farklı proje büyüklükleri ve gereksinimleri için farklı araçlar daha uygun olabilir. Aşağıdaki tablo, yaygın senaryolar için önerilen orkestrasyon araçlarını ve gerekçelerini göstermektedir.

Basit bir blog sitesi gibi küçük projelerde Docker Compose yeterlidir. Startup MVP’ler için Compose ile başlayıp büyüdükçe Swarm’a geçiş yapılabilir. Orta ölçekli e-ticaret siteleri için Swarm’ın otomatik ölçekleme ve load balancing özellikleri yeterlidir. Binlerce kullanıcılı SaaS platformları ise Kubernetes’in güçlü özelliklerini gerektirir.

| Senaryo | Önerilen Araç | Gerekçe |

|---|---|---|

| Blog sitesi (tek sunucu) | Docker Compose | Basit yapı, tek sunucu yeterli |

| Startup MVP (10-100 kullanıcı) | Docker Compose → Swarm | Hızlı geliştirme, gerektiğinde Swarm’a kolay geçiş |

| E-ticaret (1000+ kullanıcı) | Docker Swarm | Otomatik ölçekleme, load balancing, yönetilebilir karmaşıklık |

| SaaS Platform (10,000+ kullanıcı) | Kubernetes | Gelişmiş ölçekleme, multi-cloud, karmaşık mikroservisler |

9.6 Geçiş Yol Haritası

Bir orkestrasyon aracından diğerine geçiş aşamalı olarak yapılmalıdır. Her aşamada sisteminizin ihtiyaçlarını ve ekibinizin yeteneklerini değerlendirerek ilerlemeniz önemlidir.

İlk aşamada geliştirme ortamınızda Docker Compose kullanarak başlamalısınız. Bu aşamada basit bir YAML dosyası ile yerel geliştirme ortamınızı kolayca yönetebilirsiniz. Build direktifi sayesinde Dockerfile’ınızdan otomatik olarak image oluşturulur.

Aşama 1: Geliştirme (Docker Compose)

version: "3.8"

services:

web:

build: .

ports:

- "80:80"

Projeniz büyüdükçe ve birden fazla sunucuya ihtiyaç duymaya başladığınızda Docker Swarm’a geçiş yapabilirsiniz. Bu aşamada Compose dosyanızı küçük değişikliklerle Swarm stack dosyasına dönüştürürsünüz. Build yerine hazır image kullanır, deploy bölümünde replika sayısını ve güncelleme stratejisini belirtirsiniz.

Aşama 2: Orta Ölçek (Docker Swarm)

version: "3.8"

services:

web:

image: myapp:latest

deploy:

replicas: 3

update_config:

parallelism: 1

ports:

- "80:80"

Projeniz çok daha büyüdüğünde ve karmaşık mikroservis mimarisine geçtiğinizde Kubernetes’e migration yapabilirsiniz. Bu noktada Kompose aracını kullanarak mevcut stack dosyanızı Kubernetes YAML’ine çevirebilir veya sıfırdan Kubernetes manifestleri yazabilirsiniz.

Aşama 3: Büyük Ölçek (Kubernetes)

kompose convert -f docker-stack.yml

kubectl apply -f .

Her geçiş aşamasında sisteminizi test etmeli ve ekibinizin yeni araca adapte olması için zaman tanımalısınız. Aşamalı geçiş, riskleri minimize eder ve sorunları erkenden tespit etmenizi sağlar.

10. Güvenlik

Docker konteynerleri, uygulamalarınızı izole eder ancak bu izolasyon tek başına yeterli değildir. Güvenlik, Docker kullanımının en kritik yönlerinden biridir. Bu bölümde konteyner güvenliğini artırmak için kullanabileceğiniz araçları, teknikleri ve en iyi uygulamaları öğreneceksiniz.

Konteynerler varsayılan olarak bazı güvenlik özellikleriyle gelir ancak production ortamlarında ek güvenlik katmanları eklemeniz şarttır. Özellikle hassas verileri işleyen uygulamalarda, güvenlik açıklarını minimum seviyeye indirmek için çeşitli yöntemler uygulamalısınız.

10.1 Rootless Docker (Linux)

Normal Docker kurulumunda daemon root yetkisiyle çalışır. Bu, bir güvenlik açığı oluşturabilir çünkü konteyner içinden çıkış yapılırsa (container escape) saldırgan root erişimi kazanabilir. Rootless Docker, bu riski ortadan kaldırmak için daemon’u root olmayan bir kullanıcı ile çalıştırır.

Rootless Docker’ın mantığı şudur: daemon ve konteynerler normal kullanıcı yetkileriyle çalışır, böylece bir güvenlik açığı olsa bile saldırgan sadece o kullanıcının yetkilerine sahip olur, sistem genelinde root erişimi kazanamaz.

Rootless Docker Kurulumu (Ubuntu/Debian)

Öncelikle normal Docker daemon’unu durdurmanız gerekir. Ardından rootless kurulum scriptini çalıştırırsınız. Bu script gerekli ayarları yapar ve Docker’ı kullanıcı modu ile başlatır.

# Mevcut Docker'ı durdur

sudo systemctl disable --now docker.service docker.socket

# Rootless kurulum scriptini çalıştır

curl -fsSL https://get.docker.com/rootless | sh

# Ortam değişkenlerini ayarla

export PATH=/home/$USER/bin:$PATH

export DOCKER_HOST=unix:///run/user/$(id -u)/docker.sock

Kurulum tamamlandıktan sonra Docker komutlarını sudo olmadan çalıştırabilirsiniz. Daemon artık normal kullanıcı yetkileriyle çalışır ve konteynerler de aynı şekilde root yetkisi olmadan çalışır.

Rootless Docker’ın Avantajları ve Kısıtlamaları

Rootless Docker kullanmanın en büyük avantajı güvenliktir. Container escape senaryolarında bile saldırgan root erişimi kazanamaz. Ayrıca çok kullanıcılı sistemlerde her kullanıcı kendi Docker daemon’unu çalıştırabilir.

Ancak bazı kısıtlamaları vardır. 1024’ten küçük portları (80, 443 gibi) doğrudan bağlayamazsınız, bunun yerine port yönlendirme kullanmanız gerekir. Bazı storage driver’lar (overlay2 vb.) çalışmayabilir. Performans standart Docker’a göre biraz daha düşük olabilir.

| Avantajlar | Kısıtlamalar |

|---|---|

| Root erişimi riski yok | 1024’ten küçük portlar kullanılamaz |

| Çok kullanıcılı sistemlerde güvenli | Bazı storage driver’lar çalışmaz |

| Container escape riski minimum | Performans biraz daha düşük |

| Kullanıcı izolasyonu | Bazı network özellikleri sınırlı |

10.2 Linux Güvenlik Modülleri (Seccomp, AppArmor, SELinux)

Linux işletim sistemi, konteynerleri korumak için çeşitli güvenlik modülleri sunar. Bu modüller, konteynerlerin yapabileceklerini kısıtlar ve zararlı aktiviteleri engeller. Her biri farklı bir yaklaşımla güvenlik sağlar.

Seccomp (Secure Computing Mode)

Seccomp, konteynerin hangi sistem çağrılarını (system calls) yapabileceğini kontrol eder. Sistem çağrıları, bir programın işletim sisteminden bir şey talep etmesidir. Örneğin dosya okuma, network bağlantısı kurma veya yeni process başlatma sistem çağrılarıdır.

Docker varsayılan olarak bir seccomp profili kullanır ve tehlikeli sistem çağrılarını engeller. Örneğin reboot, swapon, mount gibi sistem çağrıları varsayılan olarak engellidir.

Kendi seccomp profilinizi de oluşturabilirsiniz. Aşağıda sadece read, write ve exit sistem çağrılarına izin veren bir profil örneği görüyorsunuz.

Örnek seccomp profili (seccomp.json):

{

"defaultAction": "SCMP_ACT_ERRNO",

"architectures": ["SCMP_ARCH_X86_64"],

"syscalls": [

{

"names": ["read", "write", "exit", "exit_group"],

"action": "SCMP_ACT_ALLOW"

}

]

}

Bu profili kullanarak bir konteyner başlatmak için:

docker run --security-opt seccomp=seccomp.json myimage

AppArmor

AppArmor, konteynerlerin dosya sistemine, network’e ve diğer kaynaklara erişimini kontrol eder. Ubuntu ve Debian sistemlerinde varsayılan olarak kuludur.

Docker otomatik olarak docker-default adlı bir AppArmor profili kullanır. Bu profil konteynerin hassas sistem dizinlerine yazmasını engeller, örneğin /sys, /proc gibi dizinler korunur.

Kendi AppArmor profilinizi de oluşturabilirsiniz. Örneğin sadece /tmp dizinine yazma izni veren bir profil:

# AppArmor profili oluştur (/etc/apparmor.d/docker-nginx)

profile docker-nginx flags=(attach_disconnected,mediate_deleted) {

#include <abstractions/base>

file,

/tmp/** rw,

deny /proc/** w,

deny /sys/** w,

}

# Profili yükle

sudo apparmor_parser -r -W /etc/apparmor.d/docker-nginx

# Konteyner başlatırken kullan

docker run --security-opt apparmor=docker-nginx nginx

SELinux

SELinux (Security-Enhanced Linux), Red Hat, CentOS ve Fedora sistemlerinde kullanılan güvenlik modülüdür. AppArmor’a benzer şekilde çalışır ancak daha karmaşık ve güçlüdür.

SELinux her dosyaya, process’e ve network portuna bir etiket (label) atar. Konteynerler varsayılan olarak svirt_lxc_net_t etiketiyle çalışır ve sadece svirt_sandbox_file_t etiketli dosyalara erişebilir.

Daha önce Bölüm 6’da gördüğünüz :Z etiketi de SELinux ile ilgilidir. Volume mount ederken :Z kullanırsanız, Docker o dizine otomatik olarak konteyner erişimi için doğru etiketi atar.

docker run -v /mydata:/data:Z myimage

Kernel Capabilities

Linux kernel, root yetkilerini küçük parçalara böler. Bu parçalara “capability” denir. Örneğin network ayarlarını değiştirmek için CAP_NET_ADMIN, dosya sahipliğini değiştirmek için CAP_CHOWN capability’si gerekir.

Docker varsayılan olarak konteynerlere sınırlı sayıda capability verir. Gereksiz capability’leri kaldırarak güvenliği artırabilirsiniz.

Tüm capability’leri kaldırma:

docker run --cap-drop=ALL myimage

Sadece belirli capability’leri verme:

docker run --cap-drop=ALL --cap-add=NET_BIND_SERVICE myimage

Bu örnekte tüm capability’ler kaldırılıyor ve sadece NET_BIND_SERVICE (1024’ten küçük portlara bind olma) veriliyor.

10.3 Image Tarama ve Güvenlik Araçları

Konteyner güvenliğinin önemli bir parçası da kullandığınız image’lerin güvenli olmasıdır. Image’ler içinde güvenlik açıkları (vulnerabilities) olabilir. Bu açıkları tespit etmek için image tarama araçları kullanılır.

Docker Bench for Security

Docker Bench for Security, Docker kurulumunuzu en iyi güvenlik pratiklerine göre kontrol eden otomatik bir scripttir. CIS Docker Benchmark standartlarını kontrol eder.

Kurulum ve kullanım:

git clone https://github.com/docker/docker-bench-security.git

cd docker-bench-security

sudo sh docker-bench-security.sh

Script çalıştırıldığında yüzlerce kontrol yapar ve sonuçları raporlar. Her kontrol için PASS, WARN veya INFO durumu verir.

Örnek çıktı:

[PASS] 1.1.1 - Ensure a separate partition for containers has been created

[WARN] 1.2.1 - Ensure Docker daemon is not running with experimental features

[INFO] 2.1 - Restrict network traffic between containers

WARN durumundaki uyarıları mutlaka incelemelisiniz. Bunlar potansiyel güvenlik sorunlarını gösterir.

Trivy ile Image Tarama

Trivy, Docker image’lerindeki güvenlik açıklarını tespit eden açık kaynaklı bir araçtır. Kullanımı çok basittir ve hızlı sonuç verir.

Kurulum:

# Linux

wget -qO - https://aquasecurity.github.io/trivy-repo/deb/public.key | sudo apt-key add -

echo "deb https://aquasecurity.github.io/trivy-repo/deb $(lsb_release -sc) main" | sudo tee -a /etc/apt/sources.list.d/trivy.list

sudo apt update

sudo apt install trivy

# macOS

brew install trivy

Image tarama:

trivy image nginx:latest

Trivy, image içindeki tüm paketleri kontrol eder ve bilinen güvenlik açıklarını listeler. Her açık için CVE numarası, şiddet seviyesi (CRITICAL, HIGH, MEDIUM, LOW) ve çözüm önerisi gösterir.

Örnek çıktı:

nginx:latest (debian 11.6)

==========================

Total: 45 (CRITICAL: 5, HIGH: 12, MEDIUM: 20, LOW: 8)

┌───────────────┬────────────────┬──────────┬────────┬─────────────────────┐

│ Library │ Vulnerability │ Severity │ Status │ Fixed Version │

├───────────────┼────────────────┼──────────┼────────┼─────────────────────┤

│ openssl │ CVE-2023-12345 │ CRITICAL │ fixed │ 1.1.1w-1 │

│ curl │ CVE-2023-54321 │ HIGH │ fixed │ 7.88.1-1 │

└───────────────┴────────────────┴──────────┴────────┴─────────────────────┘

CRITICAL ve HIGH seviyedeki açıkları mutlaka düzeltmelisiniz. Bunun için genellikle image’i güncellemeniz veya farklı bir base image kullanmanız gerekir.

Diğer Image Tarama Araçları

Trivy dışında başka araçlar da vardır:

| Araç | Açıklama | Kullanım |

|---|---|---|

| Clair | CoreOS tarafından geliştirilen image tarayıcı | API tabanlı, CI/CD’ye entegre edilebilir |

| Anchore | Detaylı policy kontrolü yapabilen tarayıcı | Kurum politikalarına göre image onaylama |

| Snyk | Hem image hem de kod taraması yapan ticari araç | Gelişmiş raporlama ve izleme |

| Grype | Trivy’ye benzer, hızlı ve basit tarayıcı | Komut satırı kullanımı kolay |

10.4 Secrets Yönetimi

Şifreler, API anahtarları, sertifikalar gibi hassas bilgileri (secrets) konteyner içinde güvenli şekilde saklamak kritiktir. Asla bu bilgileri Dockerfile’a veya image’e hard-code etmemelisiniz.

Docker Swarm Secrets

Docker Swarm, secrets için yerleşik bir sistem sunar. Secrets şifrelenerek saklanır ve sadece yetkili konteynerlere mount edilir.

Secret oluşturma:

# Dosyadan secret oluşturma

echo "myDBpassword123" | docker secret create db_password -

# Dosyadan secret oluşturma

docker secret create db_config /path/to/config.json

Serviste secret kullanma:

docker service create \

--name myapp \

--secret db_password \

myimage

Konteyner içinde secret /run/secrets/ dizininde dosya olarak görünür:

# Konteyner içinde

cat /run/secrets/db_password

# Çıktı: myDBpassword123

Docker Compose ile secret kullanımı:

version: "3.8"

services:

web:

image: myapp

secrets:

- db_password

secrets:

db_password:

external: true

Environment Variables ile Secret (Önerilmez)

Bazı durumlarda environment variable kullanmak zorunda kalabilirsiniz ancak bu yöntem güvenli değildir. Environment variable’lar docker inspect ile görülebilir.

docker run -e DB_PASSWORD=secret123 myimage

Bu yöntem yerine mutlaka Docker secrets veya Vault kullanmalısınız.

HashiCorp Vault Entegrasyonu

Production ortamlarında daha gelişmiş secret yönetimi için HashiCorp Vault kullanılabilir. Vault, secrets’ı merkezi bir yerde saklar, şifreler ve erişim kontrolü sağlar.

Vault’un temel çalışma mantığı şudur: uygulamanız başladığında Vault’tan token alır, bu token ile secrets’ı çeker ve kullanır. Secrets asla image içinde veya environment variable’da saklanmaz.

Basit Vault kullanım örneği:

# Vault'a secret yazma

vault kv put secret/db password=myDBpassword

# Konteyner içinden secret okuma

vault kv get -field=password secret/db

Vault entegrasyonu için genellikle bir init container veya sidecar pattern kullanılır. Bu konular daha ileri seviye olduğu için burada detaya girmiyoruz.

10.5 Container Hardening Pratikleri

Konteynerlerinizi güvenli hale getirmek için uygulamanız gereken pratikler vardır. Bu pratikler savunmanızı katmanlı hale getirir (defense in depth).

USER Direktifi Kullanımı

Dockerfile’da varsayılan olarak konteyner root kullanıcısı ile çalışır. Bu büyük bir güvenlik riskidir. Mutlaka non-root kullanıcı ile çalıştırmalısınız.

Kötü örnek:

FROM node:18

WORKDIR /app

COPY . .

CMD ["node", "app.js"]

# Root olarak çalışıyor!

İyi örnek:

FROM node:18

WORKDIR /app

COPY . .

# Non-root kullanıcı oluştur

RUN useradd -m -u 1001 appuser && \

chown -R appuser:appuser /app

# Bu kullanıcıya geç

USER appuser

CMD ["node", "app.js"]

Artık konteyner appuser ile çalışır. Bir güvenlik açığı olsa bile saldırgan root yetkisi kazanamaz.

Read-Only Filesystem

Konteynerin filesystem’ini read-only yaparak saldırganın zararlı dosya yazmasını engelleyebilirsiniz.

docker run --read-only --tmpfs /tmp myimage

Uygulama geçici dosyalar yazmak zorundaysa tmpfs kullanabilirsiniz. tmpfs RAM’de çalışır ve konteyner kapandığında silinir.

Docker Compose ile:

services:

web:

image: myapp

read_only: true

tmpfs:

- /tmp

Gereksiz Capability’leri Kaldırma

Daha önce bahsettiğimiz gibi capability’leri kaldırarak saldırganın yapabileceklerini kısıtlayabilirsiniz.

docker run \

--cap-drop=ALL \

--cap-add=NET_BIND_SERVICE \

myimage

Network İzolasyonu

Her konteyner için ayrı network oluşturarak servisleri izole edebilirsiniz. Böylece bir konteyner hack’lense bile diğerlerine erişemez.

# Frontend network

docker network create frontend

# Backend network

docker network create backend

# Web servisi sadece frontend'e bağlı

docker run --network frontend web

# API servisi her ikisine de bağlı

docker run --network frontend --network backend api

# Database sadece backend'e bağlı

docker run --network backend db

Resource Limitleri

Konteyner kaynak tüketimini sınırlandırarak DoS (Denial of Service) saldırılarını engelleyebilirsiniz.

docker run \

--memory="512m" \

--cpus="1.0" \

--pids-limit=100 \

myimage

Bu limitler sayesinde bir konteyner tüm sistemi çökertmez.

Image Güncelliği

Kullandığınız base image’leri düzenli olarak güncellemelisiniz. Eski image’ler bilinen güvenlik açıkları içerebilir.

# Image'leri güncelle

docker pull nginx:latest

docker pull node:18-alpine

Ayrıca production’da latest tag’i yerine belirli versiyonlar kullanmalısınız:

# Kötü

FROM node:latest

# İyi

FROM node:18.19.0-alpine

Güvenlik Kontrol Listesi

Konteyner güvenliği için uygulamanız gereken temel pratiklerin özeti:

Dockerfile Güvenliği:

- Non-root kullanıcı kullan (USER direktifi)

- Minimal base image seç (alpine, distroless)

- Multi-stage build ile gereksiz araçları kaldır

- Secrets’ı image’e gömme

- Belirli image versiyonları kullan (latest değil)

Runtime Güvenliği:

- Rootless Docker kullan

- Read-only filesystem aktif et

- Gereksiz capability’leri kaldır

- Resource limitleri belirle

- Network izolasyonu yap

- Seccomp/AppArmor/SELinux kullan

Image Güvenliği:

- Düzenli image tarama yap (Trivy)

- Base image’leri güncelle

- Docker Bench for Security çalıştır

- Sadece güvenilir registry’lerden image çek

Secrets Yönetimi:

- Docker Swarm secrets veya Vault kullan

- Environment variable’da secret saklama

- Secrets’ı logla

- Secrets’ı version control’e koyma

Bu pratikleri uyguladığınızda konteynerlerinizin güvenliği önemli ölçüde artar. Güvenlik katmanlı bir yaklaşım gerektirir, tek bir yöntem yeterli olmaz.

11. Kaynak Kısıtları & Performans Yönetimi

Docker konteynerleri varsayılan olarak host sistemin tüm kaynaklarını kullanabilir. Bu durumda bir konteyner tüm CPU’yu veya RAM’i tüketebilir ve diğer konteynerlerin veya sistemin çökmesine neden olabilir. Kaynak kısıtlamaları belirlemek, hem sistem kararlılığı hem de performans için kritiktir.

Bu bölümde konteynerlere kaynak limitleri nasıl koyulur, Linux’un bu limitleri nasıl uyguladığı ve farklı platformlarda kaynak yönetiminin nasıl yapıldığını öğreneceksiniz.

11.1 Memory ve CPU Limitleri

Docker, konteynerlerin kullanabileceği bellek ve işlemci miktarını sınırlandırmanıza olanak tanır. Bu limitler sayesinde bir konteynerin aşırı kaynak tüketmesini engelleyebilir, sistemin kararlı çalışmasını sağlayabilirsiniz.

Memory (Bellek) Limitleri

Bellek limitleri belirlemek, konteyner çökmelerini ve sistem genelinde bellek tükenmesini önler. Bir konteyner belirlenen limiti aşmaya çalıştığında Linux kernel’i OOM (Out Of Memory) Killer devreye girer ve konteyneri durdurur.

Basit memory limiti:

docker run --memory="512m" nginx

Bu örnekte konteyner maksimum 512 MB RAM kullanabilir. Limit aşılırsa konteyner otomatik olarak kapatılır.

Memory swap ayarı:

docker run --memory="512m" --memory-swap="1g" nginx